Entre serment d’Hippocrate et code source : la déontologie médicale à l’épreuve de l’intelligence artificielle

Face à l’automatisation, les Ordres réinventent la déontologie : responsabilité, consentement, biais. Un tournant en 2025 pour la médecine.

Responsabilité médicale intelligence artificielle : en 2025, plus d’un tiers des établissements de santé français utilisent un outil d’IA dans leur pratique quotidienne. Diagnostic, orientation, prescription… La machine s’invite au cœur de la décision clinique. Mais une question traverse désormais les consultations : quand le logiciel propose, qui dispose ? Et surtout… qui est responsable ?

L’IA a déjà modifié la pratique. La responsabilité aussi.

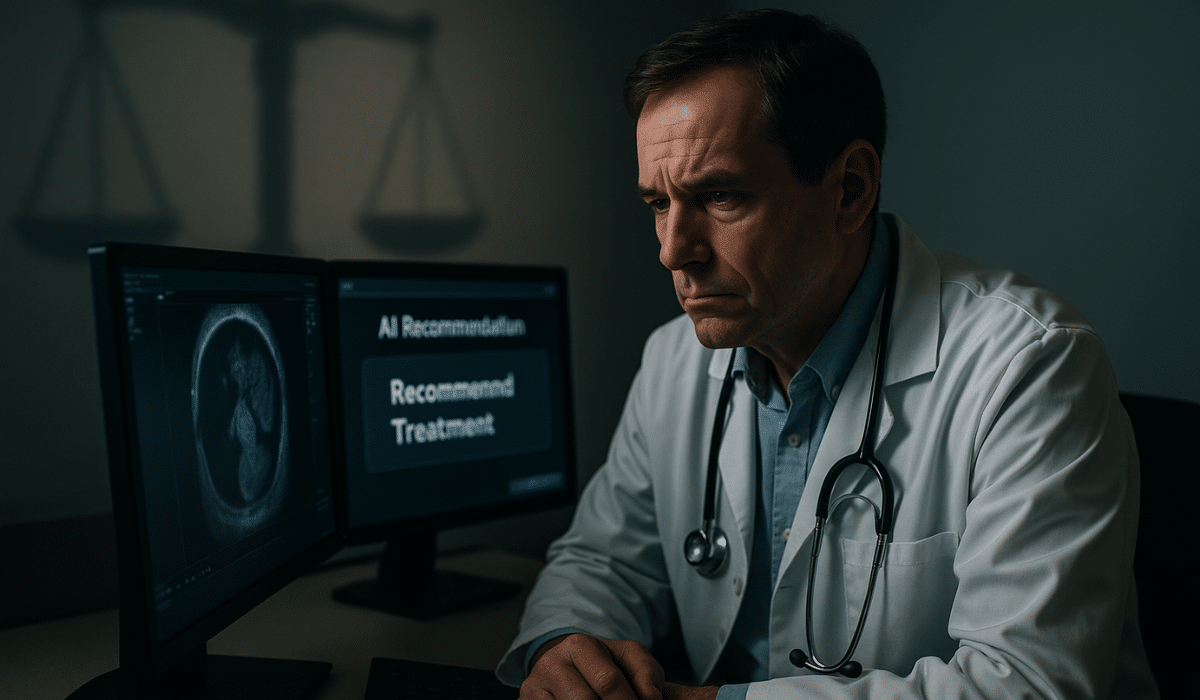

Dans un centre de cancérologie de l’Ouest, une patiente de 82 ans se voit proposer une chimiothérapie allégée par un outil d’aide à la décision. Le médecin choisit une option plus intensive, au vu du bon état général. Quelques semaines plus tard, la famille s’appuie sur l’avis algorithmique pour remettre en cause le choix clinique.

Ce genre de situation, autrefois marginale, se banalise. En 2025, plus de 35 % des établissements français utilisent un dispositif intégrant de l’intelligence artificielle, principalement pour le diagnostic, l’aide à la prescription ou l’orientation patient. Et derrière l’efficacité perçue, une question sensible : si l’algorithme propose et le soignant dispose, qui assume en cas d’écart ?

Une responsabilité désormais partagée, mais floue

Historiquement, la médecine repose sur un principe simple : le médecin est seul responsable de ses décisions. Mais le serment d’Hippocrate ne dit rien des scores de tri, des recommandations automatiques ou des interfaces assistées par IA. Et dans les faits, le pacte soignant se transforme.

Pour encadrer ce virage, l’Union européenne a adopté le Règlement IA (IA Act) en août 2024. Il classe les systèmes de santé comme “à haut risque” et impose transparence, supervision humaine et documentation des biais. S’y ajoutent la directive NIS2 (cybersécurité), le RGPD (protection des données) et depuis mars 2025, le EHDS (Espace Européen des Données de Santé).

Mais ces cadres restent souvent techniques. Pour un médecin, savoir qu’un algorithme est “conforme au RIA” ne garantit ni sa fiabilité clinique, ni sa pertinence au cas par cas. Le droit encadre la machine. Il ne résout pas les dilemmes éthiques.

Les Ordres montent au front

Le Conseil national de l’Ordre des médecins a réagi. En 2025, un nouveau chapitre déontologique voit le jour : la co-décision médecin-algorithme. Une checklist obligatoire accompagne les praticiens : certification du dispositif, vérification du journal de bord, identification des biais, information au patient, documentation des divergences.

Objectif : poser des repères clairs, sans rejeter la technologie ni tomber dans la confiance aveugle. Mais sur le terrain, la mesure alourdit les consultations. Elle accentue aussi une nouvelle fatigue : celle du clinicien devenu superviseur d’algorithmes.

Dans les services, les tensions montent

Radiologie, dermatologie, gynécologie : les spécialités les plus exposées à l’IA témoignent. Les radiologues valident chaque alerte, même les plus absurdes. Les biais de données affectent la qualité des diagnostics, notamment sur les peaux foncées. Ces dérives ne relèvent pas d’une erreur de manipulation, mais d’un biais systémique encore mal géré.

Et les conséquences sont bien réelles. Selon le rapport 2025 de France Assos Santé, les réclamations liées à l’IA ont bondi de 42 % en un an. Dans un cas devenu emblématique, un généraliste ayant suivi une recommandation IA est mis en cause après une complication. Le tribunal relaxe le médecin… et condamne l’éditeur.

Réglementer ne suffit plus : il faut gouverner

À l’échelle européenne, le triptyque IA Act – MDR – EHDS pose les bases. Mais il reste à articuler ces textes avec la réalité clinique. C’est le sens de la démarche portée par des hôpitaux pilotes, qui n’attendent plus que les outils soient “conformes” : ils participent activement à leur validation.

Avant de déployer un DMIA, certains établissements exigent désormais une évaluation clinique complète, couplée à une analyse éthique. Ils demandent la traçabilité des décisions algorithmiques, des tests sur des populations diverses, et un suivi post-market rigoureux.

Biais invisibles, risques bien réels : pourquoi la surveillance ne doit jamais s’arrêter

Un algorithme, aussi performant soit-il à son lancement, n’est pas figé dans le marbre. Il évolue avec les données qu’on lui donne, les usages qu’on en fait… et parfois, avec les biais qu’il reproduit. D’où la nécessité d’une surveillance continue, sur le modèle de la pharmacovigilance.

Dans les hôpitaux, cette vigilance reste inégale. Peu d’établissements disposent aujourd’hui de protocoles standardisés pour remonter les alertes, identifier les effets indésirables ou mesurer la performance réelle des systèmes IA une fois en production. Pourtant, les biais algorithmiques ne sont pas des bugs, mais des dérives souvent structurelles : échantillons peu représentatifs, biais de genre, données obsolètes…

C’est là qu’un suivi régulier – qualité des prédictions, adaptation aux populations locales, retours utilisateurs – devient un impératif. Une IA de diagnostic ne doit pas simplement être “validée” à un instant T. Elle doit continuer à prouver sa fiabilité dans le temps, au fil des évolutions cliniques et technologiques.

HWL 2025 : un forum européen pour des règles communes

Ces questions seront au cœur de Healthcare Week Luxembourg 2025, les 7 et 8 octobre prochains. L’événement, organisé par la Fédération des Hôpitaux Luxembourgeois, veut justement créer un espace de dialogue entre professionnels de santé, régulateurs, industriels et chercheurs pour imaginer une gouvernance partagée de l’IA médicale.

Quatre piliers guideront les débats : transparence, clarté juridique, responsabilité collective et surveillance continue. L’occasion pour les établissements de santé français d’échanger sur leurs pratiques, d’anticiper les futurs standards européens et de ne plus subir, mais co-construire, la déontologie numérique de demain.

Des acteurs engagés pour une gouvernance éthique de l’IA en santé

La Healthcare Week Luxembourg 2025 est également portée par des figures clés du secteur. Françoise Liners, responsable de la cellule des Technologies de la Santé au sein du ministère de l’Économie du Luxembourg, pilote depuis plusieurs années une stratégie nationale axée sur l’innovation responsable. Elle défend une IA utile, explicable, et toujours centrée sur les usages cliniques réels.

À ses côtés, Sylvain Vitali, Secrétaire Général de la Fédération des Hôpitaux Luxembourgeois (FHL), milite pour une approche de la santé numérique ancrée dans la responsabilité collective : entre hôpitaux, industriels et régulateurs. Leur engagement commun illustre une ambition partagée : faire du Luxembourg un laboratoire de gouvernance éthique à l’échelle européenne.

Former pour ne pas subir

C’est tout l’objet du plan national de formation lancé par l’État : 119 millions d’euros pour former 500 000 professionnels d’ici fin 2025. Non pas pour transformer les médecins en data scientists, mais pour leur rendre leur autonomie. Comprendre un algorithme, c’est pouvoir lui résister.

La formation met l’accent sur l’interprétation critique, la vigilance face aux biais, et la capacité à contester une recommandation automatique. Elle s’accompagne aussi d’un effort d’acculturation institutionnelle, notamment au sein des ARS et des CHU.

L’IA n’enterre pas la médecine. Mais elle en bouscule les fondations. Elle installe la suggestion dans un monde de conviction, la probabilité dans un métier de responsabilité. Face à cela, il ne s’agit pas d’être technophile ou technophobe. Il s’agit d’être médecin. Et de le rester.